Một chút lịch sử về AI (trí tuệ nhân tạo) hi!

Cụm từ "trí tuệ nhân tạo" hay AI đã không còn quá xa lạ với chúng ta hiện nay nữa, với hàng loạt sản những phần mềm như Siri của Apple...

Cụm từ "trí tuệ nhân tạo" hay AI đã không còn quá xa lạ với chúng ta hiện nay nữa, với hàng loạt sản những phần mềm như Siri của Apple , Alexa của Amazon, Google translate etc. AI đang hiện hữu trong cuộc sống hằng ngày nhiều hơn , hỗ trợ và giải quyết những đề mà chúng ta gặp phải để đưa đến một cuộc sống ngày càng thoải mái. Nhưng không chỉ có vậy , AI cũng đang đe doạ chúng ta về vấn đề việc làm khi các chuyên gia dự báo rằng trong tướng lai đến 50% số việc làm sẽ được thay thế bởi trí tuệ nhân tạo. Vậy hôm nay chúng ta sẽ tìm hiểu quá trình hình thành của AI để xem tại sao từ một cỗ máy vô chi mà dần dần lại có trí tuệ.

Đọc thêm:

Liệu máy móc có thể nghĩ - Can Machines Think?

Trong nửa đầu thế kỷ 20, khoa học viễn tưởng đã làm cho thế giới quen thuộc với khái niệm robot thông minh nhân tạo. Bắt đầu với Tin man “heartless” từ Phù thủy xứ Oz và tiếp tục với người máy hình người đóng giả Maria ở Metropolis. Vào những năm 1950, chúng ta đã có một thế hệ các nhà khoa học, nhà toán học và triết học với khái niệm trí tuệ nhân tạo (hay AI) đã được đồng hóa trong tâm trí họ về mặt văn hóa. Một trong những người như vậy là Alan Turing, một nhà đa khoa trẻ tuổi người Anh, người đã khám phá khả năng toán học của trí tuệ nhân tạo. Turing đề xuất rằng con người sử dụng thông tin có sẵn cũng như lý do để giải quyết vấn đề và đưa ra quyết định, vậy tại sao máy móc lại không thể làm được điều tương tự? Đây là khung logic trong bài báo năm 1950 của ông, Máy tính và Trí thông minh, trong đó ông thảo luận về cách chế tạo các máy thông minh và cách kiểm tra trí thông minh của chúng.

Đọc thêm:

Để cho việc theo đuổi là có thể

Thật không may, nếu chỉ có nói không thôi là không thể. Điều gì đã ngăn Turing bắt đầu làm việc ngay lúc đó? Đầu tiên, máy tính cần thay đổi về những thứ cơ bản. Trước năm 1949, máy tính thiếu điều kiện tiên quyết quan trọng đối với trí thông minh: chúng không thể lưu trữ các lệnh mà chỉ thực thi chúng. Nói cách khác, máy tính có thể được cho biết phải làm gì nhưng không thể nhớ chúng đã làm gì. Thứ hai, máy tính cực kỳ đắt tiền. Vào đầu những năm 1950, chi phí thuê một chiếc máy tính lên tới 200.000 USD một tháng. Chỉ có các trường đại học danh tiếng và các công ty công nghệ lớn mới có đủ khả năng hoạt động trong những vùng nước chưa được khám phá này. Cần phải có bằng chứng về khái niệm cũng như sự vận động từ những người nổi tiếng để thuyết phục các nguồn tài trợ rằng trí thông minh máy móc đáng để theo đuổi.

Một hội nghị đã bắt đầu tất cả

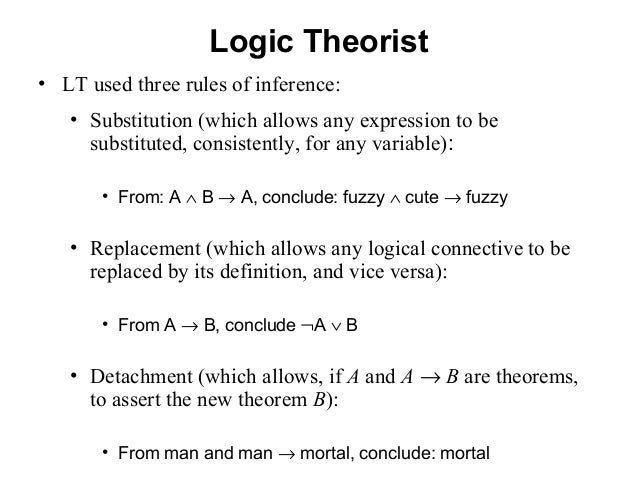

Năm năm sau, câu hỏi của Turing được thực hiện thông qua Allen Newell, Cliff Shaw và Herbert Simon được gọi là Logic Theorist. Logic Theorist là một chương trình được thiết kế để bắt chước các kỹ năng giải quyết vấn đề của con người và được tài trợ bởi Công ty Cổ phần Nghiên Cứu và Phát Triển (RAND). Nó được nhiều người coi là chương trình trí tuệ nhân tạo đầu tiên và đã được trình bày tại Dự án Nghiên Cứu Mùa Hè Dartmouth về Trí Tuệ Nhân tạo (DSRPAI) do John McCarthy và Marvin Minsky tổ chức vào năm 1956. Trong hội nghị lịch sử này, McCarthy, tưởng tượng ra một nỗ lực hợp tác tuyệt vời, đã mang lại cùng các nhà nghiên cứu hàng đầu từ nhiều lĩnh vực khác nhau cho một cuộc thảo luận kết thúc mở về trí tuệ nhân tạo, thuật ngữ mà ông đặt ra tại chính sự kiện này. Đáng buồn thay, hội nghị không như mong đợi của McCarthy; mọi người đến và đi tùy thích, và không thống nhất được các phương pháp tiêu chuẩn cho lĩnh vực này. Mặc dù vậy, tất cả mọi người đều đồng lòng với tình cảm rằng AI là có thể đạt được. Không thể phủ nhận tầm quan trọng của sự kiện này vì nó đã xúc tác cho hai mươi năm nghiên cứu AI tiếp theo.

Đọc thêm:

Những thăng trầm khi phát triển của AI

Từ năm 1957 đến năm 1974, AI phát triển mạnh mẽ. Máy tính có thể lưu trữ nhiều thông tin hơn và trở nên nhanh hơn, rẻ hơn và dễ tiếp cận hơn. Các thuật toán học máy cũng được cải thiện và mọi người trở nên tốt hơn trong việc biết nên áp dụng thuật toán nào cho vấn đề của họ. Những minh chứng ban đầu chẳng hạn như Trình Giải Quyết Vấn Đề Chung (General Problem Solver) của Newell và Simon và ELIZA của Joseph Weizenbaum cho thấy hứa hẹn hướng tới các mục tiêu giải quyết vấn đề và giải thích ngôn ngữ nói tương ứng. Những thành công này, cũng như sự ủng hộ của các nhà nghiên cứu hàng đầu (cụ thể là những người tham dự DSRPAI) đã thuyết phục các cơ quan chính phủ như Cơ Quan Dự Án Nghiên Cứu Tiên Tiến Quốc Phòng (DARPA) tài trợ cho nghiên cứu AI tại một số cơ sở. Chính phủ đặc biệt quan tâm đến một cỗ máy có thể phiên âm và dịch ngôn ngữ nói cũng như xử lý dữ liệu thông lượng cao. Sự lạc quan đã cao và kỳ vọng thậm chí còn cao hơn. Năm 1970, Marvin Minsky nói với tạp chí Life, “từ ba đến tám năm nữa chúng ta sẽ có một cỗ máy với trí thông minh chung của một con người trung bình”. Tuy nhiên, mặc dù đã có bằng chứng cơ bản về nguyên tắc, nhưng vẫn còn một chặng đường dài phía trước để đạt được các mục tiêu cuối cùng của xử lý ngôn ngữ tự nhiên, tư duy trừu tượng và tự nhận thức.

Việc phá vỡ lớp sương mù ban đầu của AI đã làm lộ ra một núi trở ngại. Điều lớn nhất là thiếu sức mạnh tính toán để thực hiện bất kỳ điều gì đáng kể: máy tính đơn giản là không thể lưu trữ đủ thông tin hoặc xử lý nó đủ nhanh. Ví dụ, để giao tiếp, người ta cần biết nghĩa của nhiều từ và hiểu chúng bằng nhiều cách kết hợp. Hans Moravec, một nghiên cứu sinh tiến sĩ của McCarthy vào thời điểm đó, nói rằng "máy tính vẫn còn quá yếu để thể hiện trí thông minh hàng triệu lần " Khi sự kiên nhẫn giảm dần, nguồn tài trợ cũng giảm dần và việc nghiên cứu đã chậm lại trong mười năm.

Vào những năm 1980, AI đã được hỗ trợ lại bởi hai nguồn lực: sự mở rộng của bộ công cụ thuật toán và tăng cường quỹ. John Hopfield và David Rumelhart đã phổ biến các kỹ thuật “học sâu” (Deep learning) cho phép máy tính học bằng cách sử dụng kinh nghiệm. Mặt khác, Edward Feigenbaum đã giới thiệu các hệ thống chuyên gia bắt chước quy trình ra quyết định của một chuyên gia về con người. Chương trình sẽ hỏi một chuyên gia trong một lĩnh vực về cách ứng phó trong một tình huống nhất định và khi điều này đã được học cho hầu hết mọi tình huống, những người không phải là chuyên gia có thể nhận được lời khuyên từ chương trình đó. Hệ thống chuyên gia đã được sử dụng rộng rãi trong các ngành công nghiệp. Chính phủ Nhật Bản đã tài trợ rất nhiều cho các hệ thống chuyên gia và các nỗ lực liên quan đến AI khác như một phần của Dự Án Máy Tính Thế Hệ Thứ Năm (FGCP) của họ. Từ năm 1982-1990, họ đã đầu tư 400 triệu đô la với mục tiêu cách mạng hóa xử lý máy tính, thực hiện lập trình logic và cải thiện trí tuệ nhân tạo. Thật không may, hầu hết các mục tiêu đầy tham vọng đã không được đáp ứng. Tuy nhiên, có thể lập luận rằng những tác động gián tiếp của FGCP đã truyền cảm hứng cho một thế hệ kỹ sư và nhà khoa học trẻ tài năng. Bất chấp việc tài trợ của FGCP đã ngừng hoạt động và AI không còn được chú ý nữa.

Trớ trêu thay, khi không có sự tài trợ của chính phủ và sự thổi phồng của công chúng, AI lại phát triển mạnh mẽ. Trong những năm 1990 và 2000, nhiều mục tiêu quan trọng của trí tuệ nhân tạo đã đạt được. Năm 1997, đương kim vô địch cờ vua thế giới và đại sư Gary Kasparov đã bị đánh bại bởi IBM’s Deep Blue, một chương trình máy tính chơi cờ. Trận đấu được công bố rộng rãi này là lần đầu tiên một nhà đương kim vô địch cờ vua thế giới để thua máy tính và đóng vai trò như một bước tiến lớn đối với một chương trình ra quyết định thông minh nhân tạo. Cùng năm đó, phần mềm nhận dạng giọng nói do Dragon Systems phát triển đã được triển khai trên Windows. Đây là một bước tiến lớn khác nhưng theo hướng nỗ lực giải thích ngôn ngữ nói. Có vẻ như không có sự cố nào mà máy móc không thể xử lý. Ngay cả cảm xúc của con người cũng là một trò chơi công bằng bằng chứng là Kismet, một robot do Cynthia Breazeal phát triển có thể nhận biết và thể hiện cảm xúc.

Trí tuệ nhân tạo hiện đang ở khắp mọi nơi

Hiện nay chúng ta đang sống trong thời đại của “dữ liệu lớn”, thời đại mà chúng ta có khả năng thu thập một lượng lớn thông tin quá cồng kềnh để một người có thể xử lý. Việc ứng dụng trí tuệ nhân tạo trong lĩnh vực này đã khá hiệu quả trong một số ngành công nghiệp như công nghệ, ngân hàng, tiếp thị và giải trí. Chúng ta nhận thấy rằng ngay cả khi các thuật toán không cải thiện nhiều, dữ liệu lớn và máy tính khổng lồ chỉ đơn giản là cho phép trí tuệ nhân tạo học hỏi thông qua nhồi nhét. Có thể có bằng chứng cho thấy Định Luật Moore đang chậm lại một chút, nhưng sự gia tăng dữ liệu chắc chắn không làm mất đi bất kỳ động lực nào. Những đột phá trong khoa học máy tính, toán học hoặc khoa học thần kinh đều được coi là tiềm năng vượt qua mức trần của Định Luật Moore.

Tương lai thì sao ??

Vậy điều gì đang được mong chờ trong tương lại ? Trước hết AI đang được coi là một thứ lớn lao tiếp theo ( The next big thing). Ta có thể tưởng tượng việc tương tác với một hệ thống chuyên gia trong một cuộc trò chuyện trôi chảy hoặc có một cuộc trò chuyện bằng hai ngôn ngữ khác nhau được dịch trong thời gian thực. Chúng ta cũng có thể mong đợi thấy những chiếc ô tô không người lái trên đường trong hai mươi năm tới (và điều đó là thận trọng). Về lâu dài, mục tiêu là trí thông minh chung, tức là một cỗ máy vượt qua khả năng nhận thức của con người trong mọi nhiệm vụ. Đây là đường nét của robot có tri giác mà chúng ta thường thấy trong các bộ phim. Tôi dường như không thể tưởng tượng được rằng điều này sẽ được thực hiện trong 50 năm tới. Ngay cả khi khả năng là có, các câu hỏi đạo đức sẽ đóng vai trò như một rào cản mạnh mẽ chống lại sự thành công. Khi thời điểm đó đến (nhưng tốt hơn ngay cả trước khi thời điểm đến), chúng ta sẽ cần phải có một cuộc trò chuyện nghiêm túc về chính sách máy móc và đạo đức (trớ trêu thay, cả hai đều là đối tượng cơ bản của con người), nhưng hiện tại, chúng ta sẽ cho phép AI cải thiện đều đặn và chạy đều đều trong cộng đồng.

Source:

The History of Artificial Intelligence - Science in the News

by Rockwell Anyoha Can Machines Think? In the first half of the 20th century, science fiction familiarized the world with the concept of artificially intelligent robots. It began with the “heartless” Tin man from the Wizard of Oz and continued with the humanoid robot that impersonated Maria in Metropolis. By the 1950s, we had a generation of scientists, mathematicians, and philosophers with the concept of …sitn.hms.harvard.edu

by Rockwell Anyoha Can Machines Think? In the first half of the 20th century, science fiction familiarized the world with the concept of artificially intelligent robots. It began with the “heartless” Tin man from the Wizard of Oz and continued with the humanoid robot that impersonated Maria in Metropolis. By the 1950s, we had a generation of scientists, mathematicians, and philosophers with the concept of …sitn.hms.harvard.edu

Logic Theorist - A History of Artificial Intelligence

Logic Theorist 1955 The Logic Theorist (LT), the first running artificial intelligence program, demonstrated by Allen Newell, J.C. Shaw, and Hertbert Simon at Carnegie Institute of Technology. Newell and Simon began to create the Logic Theorist before the existence of the field of artificial intelligence itself. Simon was a political scientist who had already produced classic … Continue reading Logic Theorist →ahistoryofai.com

Logic Theorist 1955 The Logic Theorist (LT), the first running artificial intelligence program, demonstrated by Allen Newell, J.C. Shaw, and Hertbert Simon at Carnegie Institute of Technology. Newell and Simon began to create the Logic Theorist before the existence of the field of artificial intelligence itself. Simon was a political scientist who had already produced classic … Continue reading Logic Theorist →ahistoryofai.com

Khoa học - Công nghệ

/khoa-hoc-cong-nghe

Bài viết nổi bật khác

- Hot nhất

- Mới nhất